大模型训练显卡选择全攻略:从架构、显存到成本的精准决策

当您准备投入大模型训练时,选择正确的GPU是决定项目成败与成本效益最关键的硬件决策。面对从消费级的RTX 4090到顶级的H100、B200等多种选择,决策远非比较“显存大小”或“核心数量”那么简单。错误的选择可能导致训练时间从数周延长到数月,或因显存不足而根本无法运行。本文将深入剖析大模型训练对算力的核心需求,并提供一套从技术指标到商业考量的系统化选型框架。

核心挑战:大模型训练为何对GPU如此“挑剔”?

大模型训练,尤其是千亿参数级别的模型,对GPU提出了三重严苛要求:

海量显存需求:模型参数、优化器状态、梯度、激活值等都需要驻留在显存中。一个1750亿参数的模型,仅存储FP16精度的参数就需要约350GB显存,远超单卡容量。

极高的计算吞吐量:训练需要处理万亿级别的Token,要求GPU具备强大的浮点计算能力(TFLOPS)和高效的张量核心(Tensor Core) 来加速矩阵运算。

高速互联与可扩展性:单卡无法容纳整个模型,必须通过多卡甚至多机分布式训练。此时,GPU间互联带宽(NVLink/InfiniBand) 成为避免通信瓶颈、提升扩展效率的生命线。

决策框架:选择显卡的五个核心维度

维度一:显存容量与模型规模的匹配度(首要条件)

显存是硬性门槛。您需要根据目标模型的参数量,估算所需的最小显存。

快速估算公式(以混合精度训练为例):

所需显存 ≈ (模型参数量 × (2 + 8 + 4 + (12~20))) / (1024³) GB2字节:FP16模型参数

8字节:优化器状态(如使用Adam,每个参数需存储动量、方差)

4字节:梯度(FP16训练时梯度通常以FP32存储)

12~20字节:激活值(与批次大小、序列长度强相关,是显存大头)

例如,训练一个70亿参数的模型,仅参数、梯度、优化器状态就可能需要 ~20GB显存,再叠加激活值,很容易超过40GB。因此,单卡显存必须显著大于模型参数等静态开销。

选型建议:

7B~13B参数模型:至少需要单卡24GB(如RTX 4090),但更推荐单卡40GB/48GB(如A100 40GB/80GB, H100) 以获得更大的批次容量和更高效的训练。

70B参数以上模型:必须使用多卡。A100/H100 80GB版本是主流选择,因其通过NVLink实现高带宽互联,能更高效地进行张量并行和流水线并行。

千亿参数模型:这是H100 SXM/PCIe或B200的领域,必须构建基于NVLink和InfiniBand的大规模集群。

维度二:计算架构与精度支持(效率关键)

不同GPU架构对不同计算精度的支持天差地别,这直接决定了训练速度。

关键架构特性:

Tensor Core(张量核心):专为矩阵乘加运算设计,是训练速度的核心。需关注其支持的精度(FP16, BF16, TF32, FP8)。例如,H100的FP8 Tensor Core能将吞吐量再翻倍,是未来大模型训练的趋势。

TF32与BF16支持:Ampere架构(A100)及以后的GPU支持TF32(内部以FP19计算),能在保持FP32数值范围的同时获得接近FP16的速度。BF16则在保持范围的同时降低精度,是当前大模型训练的主流精度。

双精度(FP64):对大模型训练不重要,可忽略。

选型建议:

优先选择Ampere(A100)或Hopper(H100)架构的GPU,它们对TF32/BF16的优化远超旧架构(如Volta V100)。

对于前沿探索,考虑支持FP8精度训练的H100,它可能带来显著的性能提升和能耗下降。

维度三:GPU间互联带宽(多卡扩展的命脉)

当模型大到需要多卡时,通信开销可能吞噬大部分计算时间。互联带宽决定了多卡扩展的效率。

关键互联技术:

NVLink(NVIDIA私有):GPU间直接高速互联,带宽远高于PCIe。例如,H100 SXM的NVLink 4.0带宽高达900GB/s,而PCIe 5.0 x16仅约128GB/s。

InfiniBand:用于服务器间互联的开放标准,带宽可达400Gb/s(约50GB/s)。

选型建议:

2~8卡单服务器训练:必须选择支持全NVLink互联的型号(如A100/H100 NVLINK版本)。切勿选择仅有PCIe连接的消费卡(如多张RTX 4090)进行紧密型模型并行,其通信瓶颈将导致扩展效率极低。

多机训练:必须确保集群配备高速InfiniBand网络(如HDR 200Gb/s或NDR 400Gb/s)。

维度四:软件栈与生态系统成熟度(隐性成本)

成熟的软件支持能大幅降低分布式训练的复杂度。

关键考量:

NVIDIA生态:拥有最成熟的工具链,如NCCL(优化集合通信)、CUDA、以及深度优化的框架(PyTorch, TensorFlow)。

特定框架支持:一些新兴框架(如Colossal-AI、DeepSpeed)对NVIDIA GPU的支持最为完善。

选型建议:

对于生产级、追求稳定和效率的大模型训练,NVIDIA数据中心GPU(A100, H100)是目前事实上的唯一成熟选择。其软硬件协同优化带来的效率提升,足以抵消其更高的购买/租赁成本。

维度五:总拥有成本(TCO):租赁与购买的权衡

购买:适合长期、满载、且需求稳定的机构。前期投入巨大,需承担折旧、运维和电费成本。

租赁(云/算力平台):对于大多数团队,这是更灵活、更具性价比的选择。您可以根据项目需求,弹性租用最合适的GPU组合,按需付费,并能持续使用最新硬件。

租赁选型黄金法则:在预算内,优先保证足够的显存总量,其次追求更高的计算吞吐和互联带宽。例如,租用8张A100 40GB在多数情况下比4张H100 80GB更适合大模型,因为它提供了更大的总显存(320GB vs 320GB)和更多的并行计算单元,价格通常也更低。

实践路线图:不同规模与阶段的显卡选择

原型验证与微调(<10B参数):

推荐:单张RTX 4090 (24GB) 或RTX 6000 Ada (48GB)。

理由:成本低,灵活性高,足以进行小规模实验、代码调试和对中小模型进行全参数微调。

中等规模训练(10B~70B参数):

推荐:租用2~8张A100 40GB/80GB(NVLink)。

理由:性能、显存和互联的完美平衡。A100是当前大模型训练的中坚力量,生态系统极为成熟,租赁市场供应充足,性价比最优。

大规模生产训练(70B~千亿参数):

推荐:租用H100 80GB集群(配备NVLink和InfiniBand)。

理由:需要最高计算吞吐和最大显存来缩短训练周期。H100的FP8和Transformer Engine能提供数倍于A100的性能,虽然单卡时租更贵,但更短的训练时间可能降低总成本。

前沿万亿参数探索:

推荐:H100 NVL或B200专用集群。

理由:这些是为超大规模模型设计的终极武器,拥有最大的显存(H100 NVL 188GB)和最高的互联带宽。

选择大模型训练显卡是一个系统工程。核心原则是:显存容量决定模型能否跑起来,计算架构和互联带宽决定训练效率,而总拥有成本(TCO)决定项目的商业可行性。

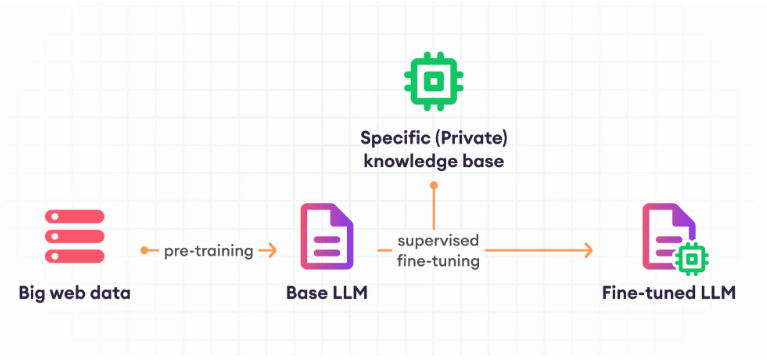

对于绝大多数团队,通过云平台或算力服务商(如极智算)按需租用A100/H100集群,是启动大模型项目风险最低、灵活性最高的路径。这允许您以可预测的成本,快速获得业界最主流的训练基础设施,将精力集中于算法和数据本身,而非复杂的硬件运维。

获取您的定制化大模型算力方案

无论您处于模型验证还是大规模生产训练阶段,我们都可提供从单卡RTX 4090到多机H100集群的灵活租赁方案,并配备高速互联与专业技术支持。

官方网站:www.jygpu.com

咨询电话:400-028-0032

服务价值:提供基于真实业务场景的算力配置建议、透明化的成本分析及稳定的集群环境,助您高效启动并完成大模型训练项目。